data management et data mining

👉 Comprendre les mécanismes à l’oeuvre dans la collecte, le traitement, et la visualisation des données marketing

Informations pratiques (pour les formations Cegos)

Accès à vos documents

Vous pouvez télécharger le support de la formation au format pdf en cliquant sur ce texte.

Horaires

La formation de déroule de 9.00 à 17.00, avec les pauses suivantes :

- Le matin : 10.30 – 10.45

- Au déjeuner : 12.15 – 13.45

- L’après-midi : 15.30 -16.00

Recueil de vos attentes

Veuillez remplir ce questionnaire.

Les informations recueillies permettront d’adapter le contenu de cette formation à vos attentes propres.

Bonnes pratiques

Cette formation n’est pas une session de débuggage individuel

Dans le cadre de cette formation, nous essayons, dans la mesure du possible, d’utiliser vos sites webs et vos problématiques comme cas pratiques. A ce titre, il est possible que l’on découvre sur votre site certains paramétrages devant être optimisés, plus ou moins en lien avec GA4.

Ce peut être par exemple un paramétrage de votre gestionnaire de balises activant le tag GA4, un souci au niveau du dataLayer qui ne remonte pas toutes les informations nécessaires, votre outil de recueil du consentement qui ne ‘passe’ pas l’information au tag GA4, etc…..Veuillez garder à l’esprit que ces deux jours ne sont pas dédiés à une session de débuggage individuel, mais bien une formation de TOUS les participants, spécifiquement sur l’utilisation de GA4.

L’ordre et la durée du temps passé sur chaque module de la formation ne sont pas figés

Selon les attentes exprimées, et pour être sûr de couvrir en premier lieu ce qui sera utilisé quotidiennement par les participants, il est possible de commencer la session directement par l’étude de l’interface utilisateur (pour des personnes rattachées au service marketing, acquisition, traffic managers, …) ou de commencer par l’implémentation, et d’y passer plus de temps (pour les développeurs).

Affichage de l'extrait du support relatif à chaque module

📌 Pour faire apparaître les slides encapsulées dans les pages, il faut ajouter un paramètre à l’url utilisée : https://www.formation.dibenn.com/formation-google-analytics-ga4/?cegos.

Ceci a pour effet de stocker l’information en session storage (Key = « intra », value = »Cegos »). la présence de ces éléments va déclencher l’affichage.

Attention : le stockage ne dure que le temps d’une session : dès que votre session sera terminée, il faudra à nouveau vous rendre sur les pages en utilisant ce paramètre : /?cegos.

Table des matières

L’ère de la donnée

Collecte

Stockage

Traitement

Visualisation et analyse

Synthèse

Glossaire

L’ère de la donnée

Support de la formation

📌 Ce support ne s’affiche que dans le cas où vous avez bien rensigné le paramètre requis dans l’url de la barre d’adresse : https://formation.dibenn.com/formation-google-analytics-ga4/?cegos

En quelques mots …

Les avancées technologiques majeures ont permis de collecter un nombre considérable de données. L’impact sociétal, politique, environnemental de ce nouveau paradigme est indéniable.

Et le big data fut ...

Les « 3 V » sont les piliers fondateurs pour comprendre pourquoi le Big Data est différent de l’informatique traditionnelle. C’est un concept théorisé au début des années 2000 (par Doug Laney) qui est essentiel afin de comprendre pourquoi Excel ne suffit plus.

1. Volume (La Quantité)

Il s’agit de la masse de données générée. En marketing, on ne parle plus de Gigaoctets, mais de Téraoctets ou de Pétaoctets.

-

Le concept : On passe du stockage de simples « transactions » (lignes de vente) au stockage de « comportements » (chaque micro-action).

-

Exemple Marketing :

-

Avant (Small Data) : Vous stockiez uniquement le fait que « Jean a acheté une paire de baskets » (1 ligne dans la base de données).

-

Maintenant (Big Data – Volume) : Vous stockez tout le parcours de Jean avant l’achat : les 40 clics précédents, les 5 images zoomées, le temps passé sur la page, les mouvements de souris et les pages qu’il a quittées. Multipliez cela par 1 million de visiteurs par mois, et vous obtenez un volume massif qui nécessite un Data Lake.

-

2. Vélocité (La Vitesse)

Il s’agit de la vitesse à laquelle les données sont créées, mais surtout la vitesse à laquelle elles doivent être analysées pour être utiles.

-

Le concept : La donnée a une « date de péremption ». Une information reçue maintenant peut ne plus avoir aucune valeur dans 2 heures.

-

Exemple Marketing :

-

Le « Temps Réel » (Real-Time Bidding) : Lorsqu’un internaute charge une page web, une enchère publicitaire a lieu en moins de 100 millisecondes pour décider quelle bannière afficher.

-

Géolocalisation : Si votre application détecte qu’un client passe devant votre magasin, la notification promotionnelle (« -20% si vous entrez maintenant ») doit partir immédiatement. Si elle part 10 minutes plus tard, le client est déjà loin : la donnée a perdu sa valeur à cause d’un manque de vélocité.

-

3. Variété (La Diversité)

C’est souvent le défi le plus complexe. Il s’agit de la multiplication des formats de données.

-

Le concept : On ne gère plus seulement des tableaux bien rangés (lignes et colonnes, appelées données structurées). On doit gérer du désordre (données non structurées).

-

Exemple Marketing :

-

Données Structurées : Le CRM (Nom, Prénom, Email, Montant achat). C’est facile à analyser.

-

Données Non Structurées (La Variété) : Pour comprendre l’image de marque, vous devez analyser des photos Instagram (reconnaissance d’image), des vidéos TikTok, des tweets (texte libre) ou des enregistrements audio du service client.

-

Le défi : Le Data Scientist doit trouver un moyen de croiser une vidéo (non structuré) avec un ticket de caisse (structuré).

-

Bonus : Les 4ème et 5ème V

On ajoute souvent deux autres « V » qui sont cruciaux pour le business :

4. Véracité : La fiabilité de la donnée. (ce que l’on pêut également regrouper sous le terme de Data Quality). Si on collecte des volumes massifs (Volume) très vite (Vélocité) mais que la moitié sont des robots ou des faux clics, l’analyse est fausse.

5. Valeur : À quoi ça sert ? Avoir beaucoup de données coûte cher (stockage). Si cela ne se transforme pas en ROI (Return on Investment) ou en meilleure connaissance client, c’est inutile.

📖 Lien avec les définitions vues dans ce module :

-

Le Data Lake est la réponse au Volume et à la Variété (on peut tout y stocker).

-

Le Data Mining est la technique pour extraire la Valeur.

-

La Data Quality assure la Véracité.

📖 Le saviez-vous ? Smart data

On désigne par ‘Smart data’ le fait d’extraire et de traiter, depuis les volumes énormes de données, les informations clés pour une analyse très granulaire.

Cycle de vie de la donnée marketing

On peut décomposer en étapes clés le cycle de vie des données marketing (notez que ce découpage en phases s’applique aux traitement de données de tout type).

Phase 1 : définition des données dont on souhaite disposer

Il s’agit de ‘traduire’ la stratégie de l’entreprise en éléments measurables.

Pour ce faire, nous considérons – entre autre – :

- Le business modèle de l’entreprise, pour en déduire les actions les plus contributives au chiffre d’affaires, et nous assurer qu’elles sont bien suivies. Ces interractions sont consignées dans le plan de taggage.

- Les Kpis clés, qui seront généralement fournis en partie par défaut par les outils que nous allons utiliser (stack technique)

Phase 2 : La Collecte & Le Consentement (« Le Comment »)

On répond à la question suivante : Comment capter la donnée légalement et techniquement ?

Le consentement et la collecte sont opérés par un écosystème (ou ‘stack’ technique) que chaque entreprise devra définir.

Illustration, pour la collecte de donnée en ligne

Cliquez sur l’image ci-dessous pour l’agrandir ![]()

Phase 3 : Stockage & Unification (« Le Où »)

On répond à la question suivante : Où va la donnée et comment l’organiser ?

En plus du stockage, il s’agit de ‘nettoyer’ la donnée pour la rendre exploitable, d’appliquer des calculs (ex : conversions d’une devise à l’autre), de s’assurer que les traitements interviennent au bon moment (ex : synchronisation entre différentes bases), et in fine de l’enrichir (avec par exemple des données du CRM, etc…).

Ces traitements sont automatisés, et proposés par défaut par les différents outils.

A titre l’illustration, vous pouvez prendre connaissance de cette vidéo, qui illustre une fonctionnalité de nettoyage des données de Zoho.

Phase 4 : Gouvernance & Sécurité (« Les Règles »)

On répond à la question suivante : Qui est responsable et comment rester dans la légalité ?

C’est ici que s’appliqueront les correctifs ‘ad hoc’, mis en place pour safisfaire les exigences légales et de data quality, à l’issue de la phase 3.

Phase 5 : Analyse & Intelligence (« Le Pourquoi »)

On répond à la question suivante : Comment transformer les chiffres en décisions ?

L’analyse des rapports mis en forme permet de mieux appréhender les points forts de l’activité, les bonnes pratiques à répliquer, et les axes d’amélioration.

Souvent, cette phase fait apparaîtrer de nouveaux besoins de données, que l’on pourra reporter en phase 1 du nouveau cycle.

Ressources utiles

📌 Réflexions sur l'impact de cette collecte massive et ininterrompue

📖 Livre ‘L’homme nu‘ (Marc Dugain & Christophe Labbé)

📖 Livre : ‘ La société d’exposition’ (Bernard E. Harcourt)

Extrait : » Certains d’entre nous sont forcés de porter un bracelet electronique à la cheville, tandis que d’autres attachent lascivement leur montre Apple à leur poignet, mais dans les deux cas, tous nos mouvements, activités et déplacements quotidiens deviennent accessibles à ceux qui disposent des technologies les plus rudimentaires […]. La télévision intelligente Samsung que nous exposons fièrement dans notre salon enregistre et partage nos conversations privées comme n’importe quel appareil de surveillance électronique – ou comme un écran orwellien que nous fixons nous-mêmes gaillardement au mur’.

📹 Film/documentaire : ‘Derrière nos écrans de fumées‘

Quiz

Collecte

Support de la formation

📌 Ce support ne s’affiche que dans le cas où vous avez bien rensigné le paramètre requis dans l’url de la barre d’adresse : https://formation.dibenn.com/formation-google-analytics-ga4/?cegos

En quelques mots …

Dans le cadre de ce module, nous n’aborderons que le périmètre marketing :

- observation des interactions survenants sur un site / une application

- optimisation des investissements publicitaire. Retenons que cette abondance de données rend possible un ciblage publicitaire de plus en plus fin … à l’échelle de l’individu.

De façon très concrète, les IA, algorithmes, IOT, …, permettent*:

- de suivre un visiteur on-off line

- de calculer sa ‘rentabilité’, en se basant sur son historique d’achat

- de trouver des profils jumeaux (lookalike profiles)

* soit par une observation directe, soit en mettant en oeuvre des alogorithmes, qui vont estimer statistiquement ce que les contraintes légales et techniques ne permettent pas de collecter directement.

Pour un annonceur, on distingue deux phases clé du parcours client (customer journey) : la phase d’acquisition et la phase de conversion. En réconciliant les données collectées à chacune des phases, il sera possible de procéder à un calcul de rentabilité très fin.

Collecte des données

Préalable :

C’est une évidence, mais il convient dans un premier temps de s’accorder sur :

– la façon dont on va nommer les composants des campagnes pour faciliter le traitement ultérieur des données. C’est l’objet de la convention de nommage des campagnes

– ce que l’on souhaite mesurer lorsque le visiteur arrive sur le site : c’est l’objet du plan de taggage, qui liste les interactions que l’on souhaite suivre, ainsi que les dénominations choisies pour les qualifier.

👉Notez que le département marketing, en tant que ‘consommateur final’ de la donnée, doit impérativement être partie prenante de la rédaction et de la mise à jour de ces deux documents.

En phase d’acquisition :

Les outils des régies publicitaires recueillent des informations sur l’audience, etc…

Les informations recueillies par les régies concernent les interactions avec les annonces, qui sont par définition réalisées sur leurs plateformes : impressions, clics, like, share, etc…

📹 Consultez la vidéo ci-dessous pour avoir un aperçu des Kpis globaux qui peuvent être recueillis. Dans le cas où elle ne s’affiche pas correctement, vous pouvez y accéder en cliquant sur ce lien.

En phase de conversion :

Lorsque le visiteur arrive sur le site de l’annonceur (après avoir cliqué sur une annonce par exemple), ses interactions avec le site de l’annonceur sont détectées et envoyées aux différents outils utilisés (régies publicitaires, outils site-centrics), à l’aide de pixels (ou scripts).

Ceux-ci sont déclenchés via un TMS (Tag Management System, ou gestionnaire de balises). Google Tag Manager est le TMS (gratuit) proposé par Google.

Les informations envoyées (sous forme de hits) sont observables depuis la console de votre navigateur (onglet ‘network’). Le principe : réalisez les actions que vous souhaitez que les visiteurs entreprennent sur votre site, et observez si les événements correspondants sont bien enregistrés.

Alternativement, vous pouvez utiliser les extensions proposées par chaque régie et chaque outil.

📌Attention toutefois :

i) dans de nombreux cas, vous ne pourrez observer ces hits que si vous avez préalablement autorisé les cookies correspondants à être déposés, que votre navigateur ne les filtre pas par défaut et que vous n’avez pas installé d’ad blocker,

ii) Il est possible que votre navigateur bloque l’extension que vous souhaitez utiliser, auquel cas la solution ‘old school’ de l’inspection de la console de votre navigateur est la plus efficace.

🧭🤖Les limitations techniques

⚖️ Les limitations légales

Les contraintes légales associées à la collecte des données digitales ont provoqué ces dernières décennies une transition majeure : d’une époque de « Far West » (collecte massive et sans contrôle) à une ère de « Responsabilité et Transparence ».

📖 Le saviez-vous ? Les aggrégateurs de flux

Au lieu de devoir établir des connecteurs avec chaque plate-forme, on peut faire appel à des agrégateurs de flux, qui peuvent aussi proposer de stocker la donnée collectée, procéder à des calculs d’aggrégats, créer des tableaux de bord pour contrôler la bonne réception des données, etc…

Voir un exemple : funnel.io

Exercices pratiques

Stockage

Support de la formation

📌 Ce support ne s’affiche que dans le cas où vous avez bien rensigné le paramètre requis dans l’url de la barre d’adresse : https://formation.dibenn.com/formation-google-analytics-ga4/?cegos

En quelques mots …

Stockage des données

Objectif:

Réunir toutes les sources de données dans un même endroit, pour procéder à leur traitement et à leur analyse.

Données structurées et non structurées

Les données structurées sont très précises et stockées dans un format prédéfini, alors que les données non structurées sont une conglomération de nombreuses données de différents types qui sont stockées dans leurs formats en mode natif. Source: https://www.talend.com/

Dans les faits, pour les besoins du pilotage des activités marketing (i.e calcul du ROI par visuel, par type de produit promu, etc..), les données sont structurées.

Stockage de la donnée traitée

Le traitement de la donnée brute nécessite à minima disposer d’outils de gestion de bases de données, d’héberger la donnée retraitée et de la renvoyer vers un outil de data visualisation.

C’est typiquement ce que proposent -entre autre- Google Cloud Platform, Microsoft Azure, AWS, etc… L’avantage est que la maintenance des infrastructures est totalement gérée; l’utilisateur n’ayant pas à se soucier de ces aspects.

Voir un exemple : Google Cloud Platform

📖 Le saviez-vous : serveur side et limitation de conservation des données

Traditionnellement, stocker ses données sur un serveur propre était plutôt l’apanage des grandes sociétés, les structures plus modestes se contentant de requêter les données stockées directement dans les bases des outils.

Mais la limitation des durées de conservation des données par les outils et la mise en place de plus en plus répandue du server to server (ou server side) rebattent les cartes. Ces évolutions obligent les annonceurs, quelle que soit leur taille, à investir dans leurs propres serveurs.

Le serveur-side est l’appelation consacrée pour indiquer que l’on envoie directement les données de serveur à serveur : du site web de l’annonceur vers le serveur de l’annonceur, puis vers le serveur de l’outil (ex : GA4, Meta, Google ads, etc…).

Exercices pratiques

Traitement

Support de la formation

📌 Ce support ne s’affiche que dans le cas où vous avez bien rensigné le paramètre requis dans l’url de la barre d’adresse : https://formation.dibenn.com/formation-google-analytics-ga4/?cegos

En quelques mots …

Nettoyage, préparation et enrichissement de la donnée

Il s’agit d’homogénéiser les formats, supprimer les valeurs aberrantes, etc…

Typiquement, pour des entreprises opérant sur différents marchés internationaux, on va appliquer un taux de change, une mise au format des dates et des nombres.

On peut aussi vouloir enrichir la donnée avec des sources externes.

Cette phase permettra de disposer du ‘matériau’ nécessaire à l’éventuelle création de données calculées, et in fine l’analyse.

Voici une vidéo qui illustre ce en quoi consiste la préparation et l’enrichissement de la donnée, et en quoi l’IA peut être utile.

Traitement de la donnée : calcul d'aggrégats, de ratios, etc...

Cela dépendra bien sûr de l’entreprise considérée, mais on peut dégager des grands ‘classiques’ :

- Calcul d’agrégats, qui vont constituer les variables ‘pivot’ utilisées par l’entreprise pour ses analyses :

- ex 1 : regroupement des données collectées tous canaux confondus par type de produit promus, type de visuel utilisé, etc…

- ex 2 : regroupement des actions sur les réseaux sociaux ‘like’, ‘share’, ‘retweet’, ‘comment’ sous la même appellation ‘engagement’.

- ex 3 : pour les données site-centric par exemple, les hits collectées sont agrégées par valeurs d’identifiants utilisateurs et sessions.

- ex 4 : calcul d’appartenance à un segment, selon le comportement observé (segmentation RFM par exemple)

- Application de règles de gestion propres à l’entreprise (ex : refacturation d’une filiale à une autre).

📖 Le saviez-vous : des chevauchements fréquents dans les outils

Les différents outils intervenant dans la collecte et le traitement des données présentent de nombreuses zones de ‘chevauchements’.

Par exemple :

i) Un aggrégateur de flux peut également servir à stocker les données. Par exemple, l’outil Funnel a diversifié son offre, et propose de stocker la donnée collectée, de contrôler la data quality (completion, cohérence), et de réaliser des tableaux de bord (visualisation).

ii) Un calcul d’aggrégat ou de nouvelle variable peut être réalisé par un outil de data-visualisation.

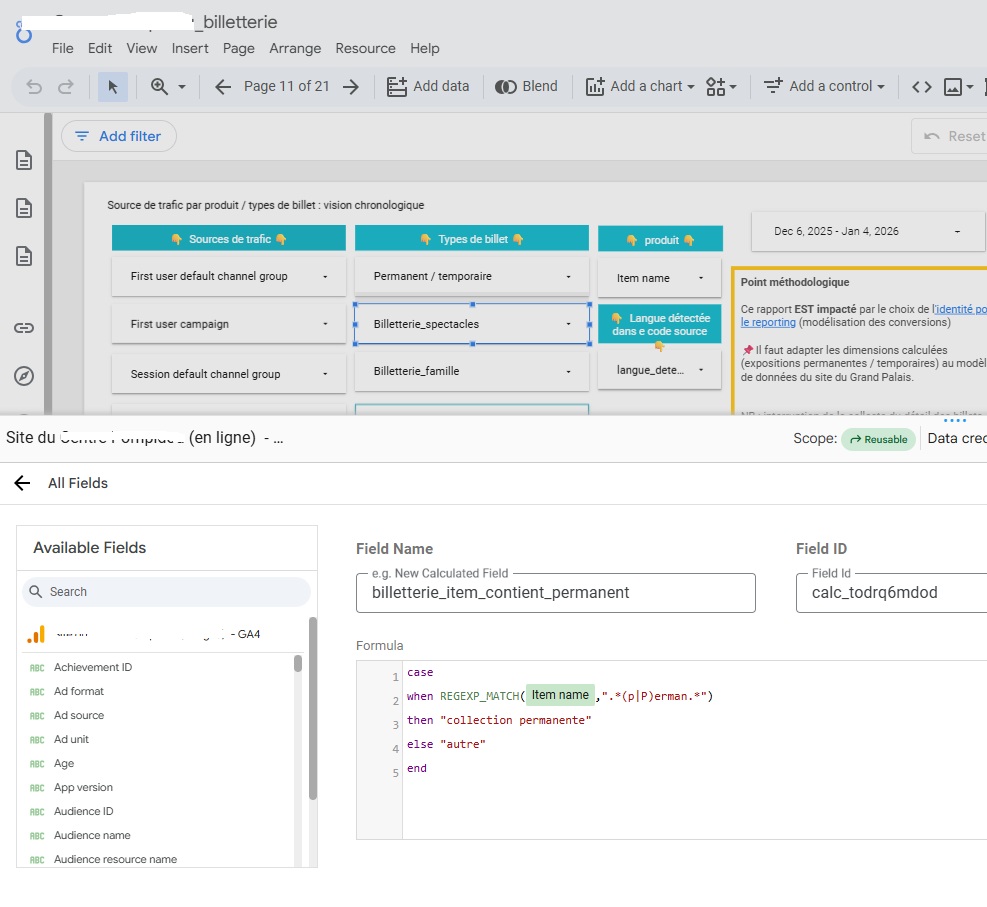

Illustration : cliquez sur l’image ci-dessous pour l’agrandir

Contexte : nous étudions les ventes en ligne d’un site de billetterie. Ici, on crée une variable qui peur prendre deux valeurs : ‘collection permanente’ ou ‘autre’, selon que le nom du produit (ici, du billet) contient ou non une chaîne de caractères définie dans une expression régulière.

Exercices pratiques

Visualisation et analyse

En quelques mots …

👉Selon l’expression consacrée, il s’agit de ‘faire parler les données’. On peut encore penser à ce célèbre adage : ‘une image vaut 1000 mots

📌 Pour un exposé approfondi, rendez-vous sur la page dédiée à la data-visualisation.

Objectif :

Rendre intelligibles les chiffres présentés, pour permettre aux marketeurs de tirer des conclusions, traduisibles en actions concrètes, afin d’améliorer au fil de l’eau la stratégie marketing.

Fonctionnement :

Comme leur nom l’indique, les outils de data-visualisation vont présenter de façon visuelle et dynamique (possibilités de filtrages, de sélection de date, etc…), les Kpis clés.

Point d’attention :

Il s’agit de trouver le bon équilibre entre la simplification à l’extrême, qui occulte les éléments clés de compréhension (eg : méthodologie employée, prise en compte de ce que chaque régie publicitaire comptabilise, ou de ce que la législation permet de récilter par zone géorgraphique), et une profusion de détails qui pourrait ‘noyer’ les utilisateurs de cette information.

Ressources utiles

📌 Quelques outils répandus de data visualisation

Voici d’autres outils connus de data visualisation

Les outils Google

- Looker studio : gratuit.

- Looker (payant)

Les outils Microsoft

- Power BI (60 jours gratuits, puis payant)

Les outils ‘indépendants’

Exercices pratiques

Synthèse

En quelques mots …

Bravo, vous êtes arrivé(e) à la conclusion de cet exposé ! Testons vos connaissances de façon ludique : venez prendre part au serious game data.